Tóm tắt hữu ích

Tổng quan: Chúng tôi giải thích cách khắc phục lỗi "Bị chặn bởi robots.txt" trong Google Search Console. Việc khắc phục lỗi này rất quan trọng đối với khả năng truy cập và khả năng hiển thị của trang web trong kết quả tìm kiếm.

Tại sao bạn có thể tin tưởng chúng tôi: Các nghiên cứu điển hình của chúng tôi cho thấy cách chúng tôi khắc phục thành công các sự cố SEO kỹ thuật như 'Bị chặn bởi robots.txt', giúp lập chỉ mục trang web nhanh hơn cho khách hàng của chúng tôi, nâng cao khả năng hiển thị của họ trên SERP.

Tại sao điều này quan trọng: Bằng cách sửa những lỗi này, bạn có thể tăng lưu lượng truy cập vào trang web, giúp công cụ tìm kiếm tìm thấy nội dung của bạn nhanh hơn, và để cuối cùng đạt được sự tăng trưởng mạnh mẽ về doanh thu.

Các điểm cần lưu ý: Chúng tôi khuyên bạn nên kiểm tra và sửa lỗi tệp robots.txt, sử dụng Công cụ kiểm tra Robots.txt của Google ,và cập nhật tệp robots.txt thường xuyên.

Nghiên cứu thêm: Chúng tôi khuyên bạn nên theo dõi các xu hướng SEO và thường xuyên đọc các blog và nghiên cứu điển hình về SEO để ngăn ngừa và quản lý những lỗi này.

Bạn cần trợ giúp để giải quyết lỗi 'Bị chặn bởi robots.txt' trong Google Search Console?

Website accessibility is a crucial factor in ensuring a good online presence and reaching a broader audience. If you're looking for scalable solutions tailored to large organizations, discover how top enterprise SEO companies drive consistent organic growth at scale. However, there can be instances when certain pages of your website become inaccessible due to restrictions set by a robots.txt file.

Điều này có thể khiến các trang đó bị loại khỏi chỉ mục của Google, ảnh hưởng đến khả năng hiển thị trang web của bạn trong kết quả tìm kiếm.

Nhưng đừng lo lắng! Hướng dẫn Embarque này sẽ hướng dẫn bạn các bước để xác định và khắc phục sự cố liên quan đến lỗi "Bị chặn bởi robots.txt" trong Google Search Console, đảm bảo trang web của bạn có thể được thu thập dữ liệu và lập chỉ mục chính xác bởi các công cụ tìm kiếm.

Vì sao nên đặt trọn niềm tin vào chúng tôi

Gặp phải lỗi "Bị chặn bởi robots.txt" trong Google Search Console có thể là một rào cản lớn đối với các doanh nghiệp nhỏ muốn cải thiện sự hiện diện trực tuyến. Tại Embarque, chúng tôi đã thành thạo trong việc giải quyết vấn đề này. Ví dụ, kinh nghiệm hợp tác với Stagetimer, một phần mềm dạng dịch vụ (SaaS) dành cho quản lý sự kiện, là minh chứng cho năng lực và chuyên môn của chúng tôi. Ban đầu, lưu lượng truy cập trang web của Stagetimer khá khiêm tốn, chỉ khoảng 40-50 lượt truy cập mỗi tháng. Nhờ chiến lược SEO của chúng tôi, lượng truy cập hàng tháng của họ đã tăng vọt lên hơn 8.838 lượt, tạo bước nhảy vọt đáng kể về doanh thu.

Một ví dụ thuyết phục khác là dự án của chúng tôi với một SaaS kỹ thuật nhắm vào một thị trường ngách. Họ đã chứng kiến lượng truy cập tự nhiên hàng tháng tăng đáng kinh ngạc gấp 60 lần chỉ trong vòng một năm sử dụng kỹ thuật xây dựng liên kết của chúng tôi, bắt đầu từ 27 lượt truy cập mỗi tháng lên đến 7.495 lượt truy cập, cải thiện đáng kể doanh thu của họ.

Các nghiên cứu điển hình này chứng minh kinh nghiệm trực tiếp và thành công của chúng tôi trong việc giải quyết các thách thức về SEO như lỗi 'Bị chặn bởi robots.txt', dẫn đến tăng trưởng đáng kể về lưu lượng truy cập và doanh thu cho các doanh nghiệp nhỏ.

'Bị chặn bởi robots.txt' trong Google Search Console có nghĩa là gì?

Khi bạn thấy thông báo lỗi "Bị chặn bởi robots.txt" trong Google Search Console, điều đó có nghĩa là Googlebot, tức là bot thu thập dữ liệu web của Google, không thể truy cập một số trang nhất định trên trang web của bạn. Điều này xảy ra vì tệp robots.txt của trang web có các lệnh giới hạn quyền truy cập của Googlebot.

Nói một cách đơn giản, điều này có nghĩa là Google không thể xem các trang cụ thể trên trang web của bạn do các quy tắc được đặt trong tệp robots.txt. Nếu các trang này được lập chỉ mục và hiển thị trong kết quả tìm kiếm, lỗi "Bị chặn bởi robots.txt" có thể gây ra sự cố.

Những lý do phổ biến gây ra lỗi 'Bị chặn bởi robots.txt'

- Cấu hình không chính xác:Nguyên nhân phổ biến nhất gây ra lỗi này là cấu hình không chính xác trong tệp robots.txt. Điều này có thể xảy ra nếu bạn sử dụng lệnh ' Disallow ' không đúng cách, vô tình chặn việc thu thập dữ liệu từ các trang quan trọng.

- Chỉ thị không cho phép quá rộng: Đôi khi, các mẫu chung trong chỉ thị ' Không cho phép' có thể vô tình chặn nhiều trang hơn dự định. Ví dụ: việc không cho phép một thư mục có thể vô tình chặn quyền truy cập vào tất cả các thư mục con và tệp trong đó.

- Quy tắc cũ hoặc lỗi thời: Trong một số trường hợp, các quy tắc robots.txt được thêm vào phiên bản trước của trang web có thể không còn phù hợp nữa, nhưng vẫn tồn tại trong tệp, vô tình chặn các nội dung hiện tại.

- Lỗi do thao tác thủ công:Lỗi đánh máy hoặc lỗi cú pháp đơn giản trong tệp robots.txt có thể dẫn đến việc vô tình chặn trang. Ví dụ: thiếu dấu gạch chéo ("/") hoặc thừa ký tự có thể thay đổi phạm vi của những gì bị chặn.

- Plugin hoặc công cụ SEO của bên thứ ba: Đôi khi, plugin hoặc công cụ SEO tự động tạo hoặc chỉnh sửa robots.txt dẫn đến việc tạo ra các quy tắc chặn nội dung quan trọng mà chủ sở hữu trang web không hề hay biết.

Cách xác định 'Bị chặn bởi robots.txt' trong Google Search Console

Để xác định lỗi 'Bị chặn bởi robots.txt' trong Google Search Console, bạn hãy làm theo các bước sau:

- Đăng nhập vào Google Search Console .

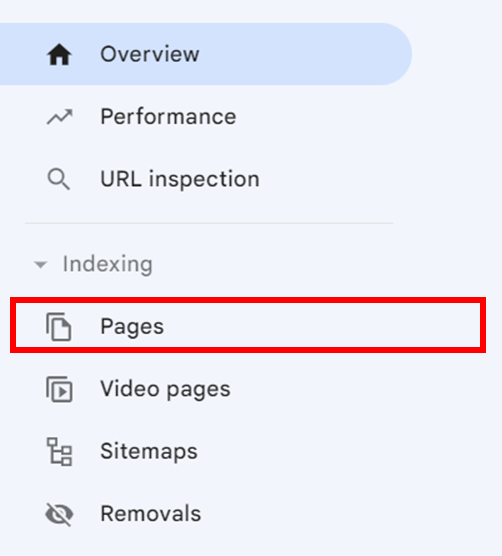

- Trong bảng điều hướng bên trái, bên dưới mục Lập chỉ mục, hãy nhấp vàoTrang.

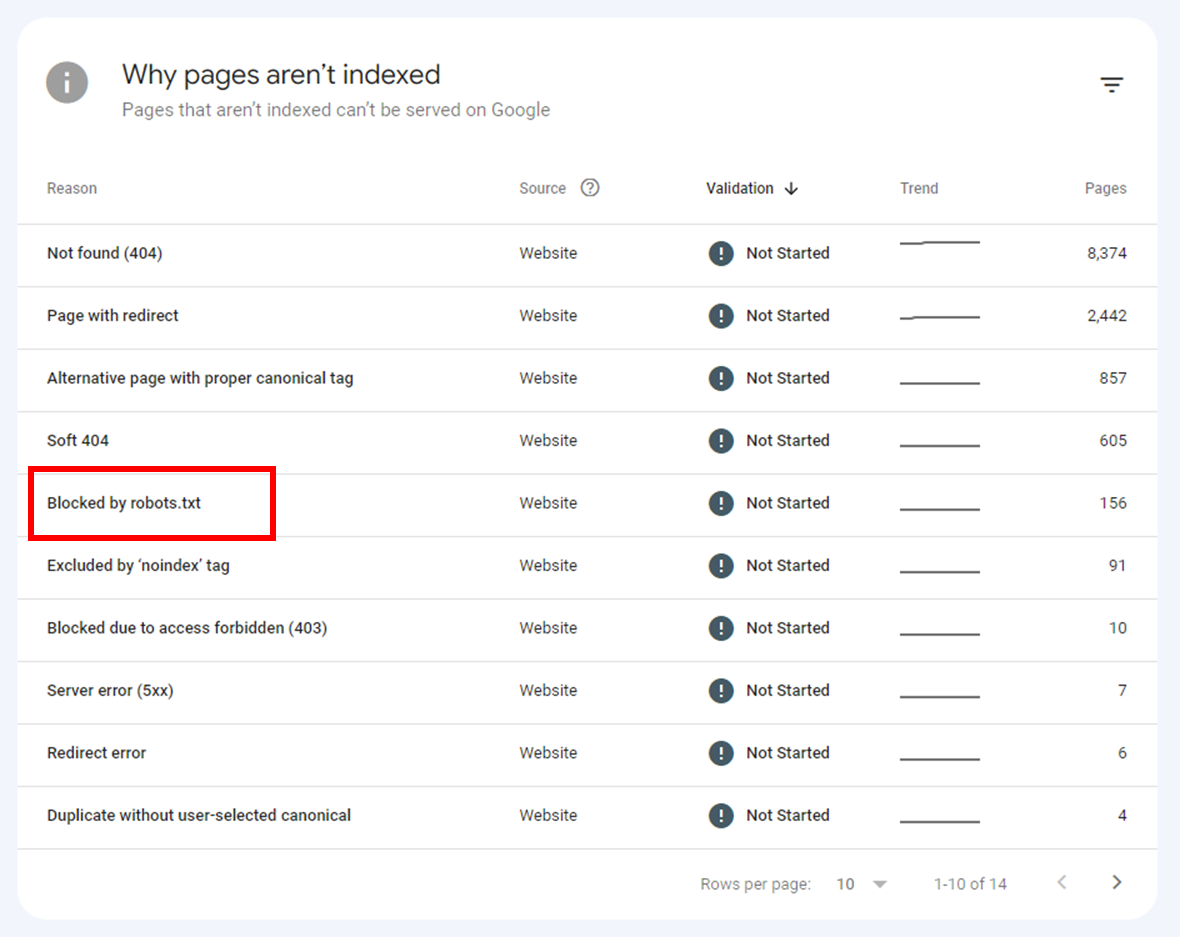

- Cuộn xuống phần Lýdo tại sao các trang không được lập chỉ mục.

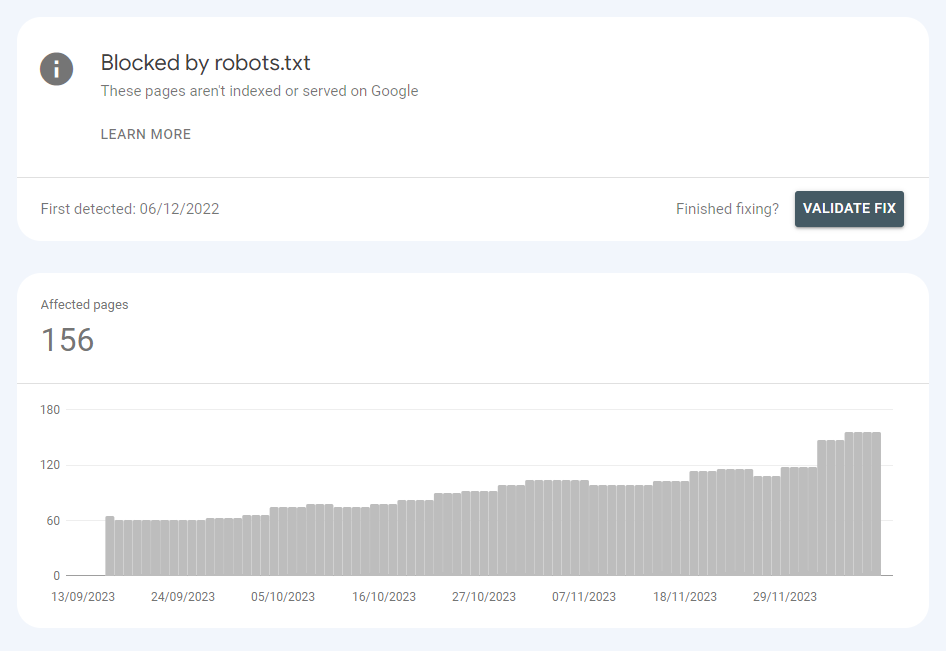

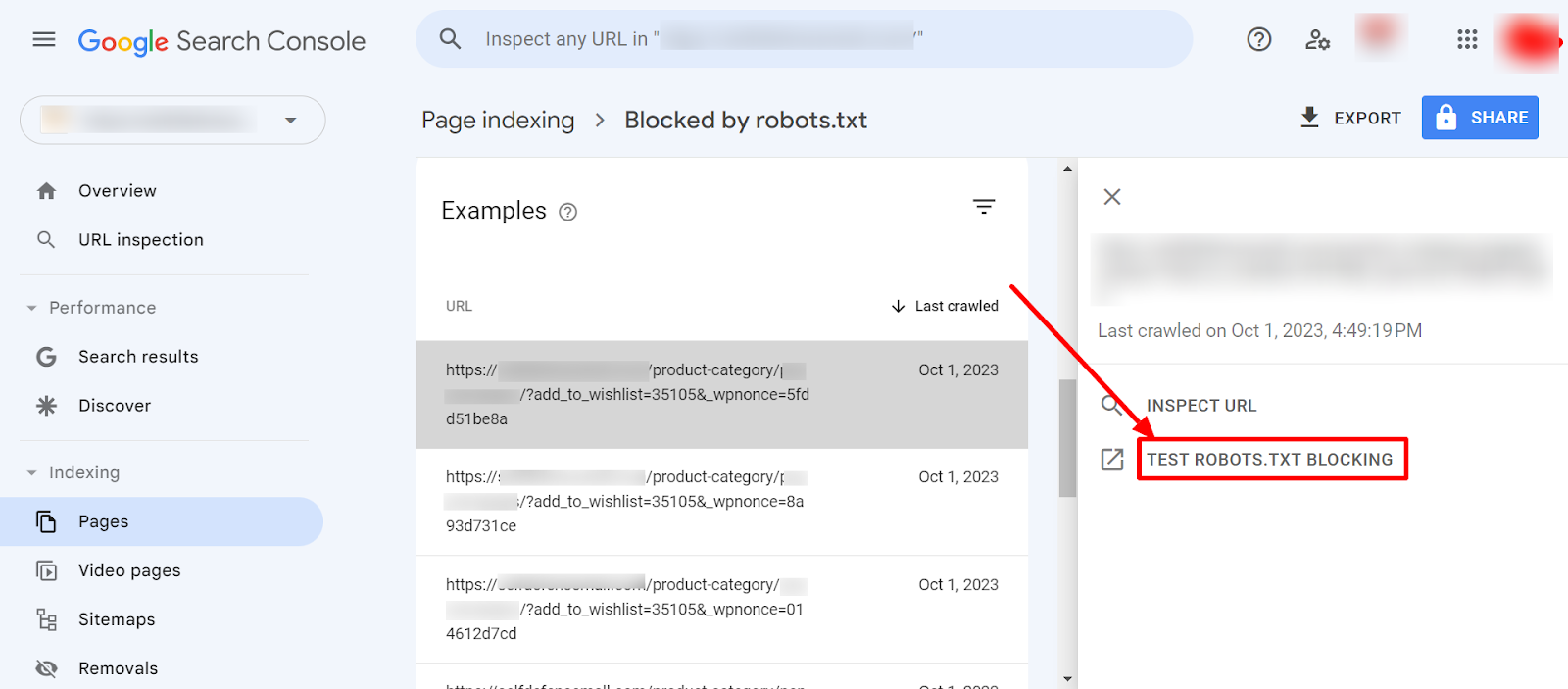

- Nhấp vào Bị chặn bởi robots.txt .

Hướng dẫn từng bước để sửa lỗi 'Bị chặn bởi robots.txt'

Sửa cấu hình tệp robots.txt

Bước 1: Xác định vị trí tệp robots.txt của bạn

Tệp robots.txt của bạn thường nằm ở thư mục gốc của trang web (ví dụ: https://www.yourwebsite.com/robots.txt). Hãy xác minh sự hiện diện và vị trí của tệp bằng cách nhập URL trang web của bạn theo sau là /robots.txt vào trình duyệt.

Bước 2: Xem lại và chỉnh sửa tệp

Truy cập tệp robots.txt trên máy chủ web của bạn. Thao tác này có thể cần đến quyền truy cập FTP hoặc công cụ quản lý tệp do dịch vụ lưu trữ web cung cấp. Hãy kiểm tra lại các chỉ thị trong tệp, đặc biệt là các dòng có " Disallow: " - đây là nơi cho biết những đường dẫn (URL path) nào đang bị chặn.

Sửa bất kỳ lỗi hoặc chỉ thị quá chung chung nào. Ví dụ: thay đổi Disallow: / (chặn toàn bộ trang web) thành các thư mục hoặc trang cụ thể hơn mà bạn muốn loại trừ.

Bước 3: Cập nhật tệp robots.txt

Sau khi thực hiện các thay đổi cần thiết, hãy lưu tệp robots.txt đã cập nhật. Tải tệp đã cập nhật lên thư mục gốc của trang web, thay thế tệp cũ.

Bước 4: Xác minh các thay đổi

Sau khi tải lên, hãy kiểm tra lại https://www.yourwebsite.com/robots.txt trong trình duyệt của bạn để đảm bảo những thay đổi đã được áp dụng.

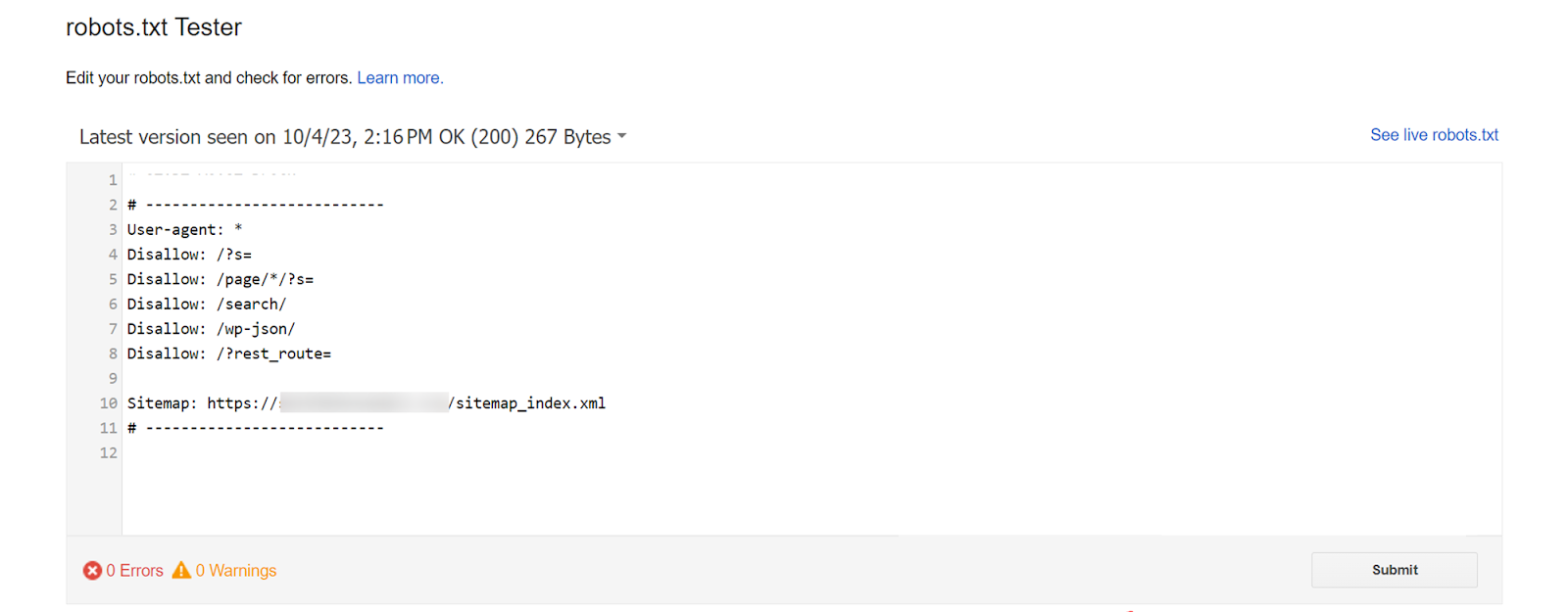

Bây giờ chúng ta sẽ sử dụng Google robots.txt Tester để kiểm tra và gửi trang để thu thập lại dữ liệu và lập chỉ mục.

Cách sử dụng công cụ kiểm tra Google robots.txt

Bước 1: Truy cập công cụ

Trong Google Search Console, hãy điều hướng đến công cụ 'robots.txt Tester ' nằm trong phần ' Thu thập thông tin '.

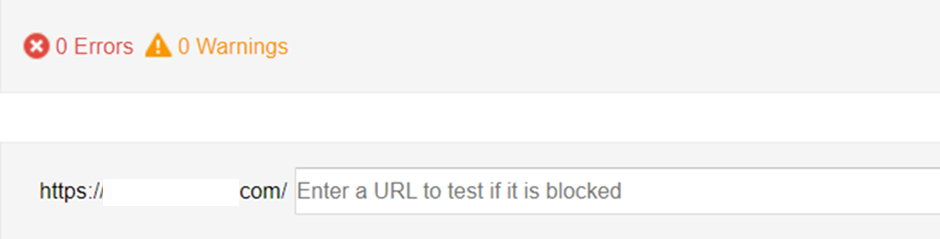

Bước 2: Nhập URL

Công cụ sẽ tự động tải nội dung tệp robots.txt của trang web của bạn. Nhập URL của một trang trên trang web của bạn vào phần text box ở cuối công cụ.

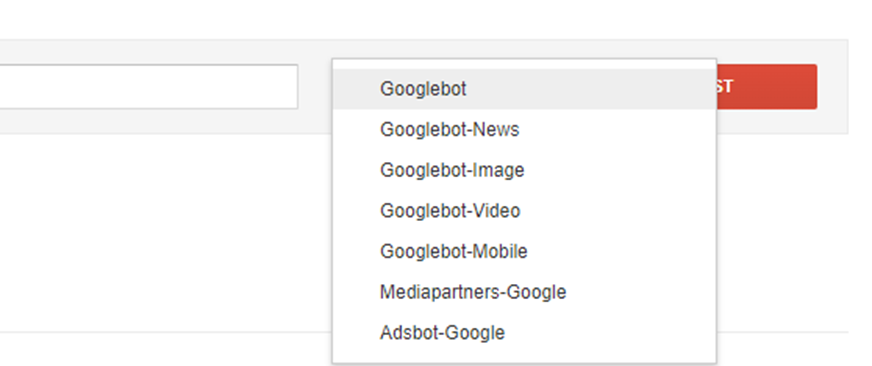

Bước 3: Chọn tác nhân người dùng

Chọn ' Googlebot ' từ danh sách tác nhân người dùng để mô phỏng cách Googlebot diễn giải tệp robots.txt của bạn.

Bước 4: Chạy thử nghiệm

Nhấp vào nút ' Kiểm tra ' để kiểm tra xem Googlebot có thể thu thập dữ liệu trang hay không. Công cụ sẽ hiển thị trang được ' Cho phép ' hay ' Bị chặn ' theo quy tắc robots.txt hiện hành.

Bước 5: Chỉnh sửa và gỡ lỗi

Nếu công cụ cho thấy một trang bị chặn, bạn có thể chỉnh sửa quy tắc robots.txt trực tiếp trong công cụ để thử nghiệm. Khi đã tìm thấy quy tắc cho phép trang đó được truy cập, hãy áp dụng thay đổi này cho tệp robots.txt hiện tại trên máy chủ của bạn.

Bước 6: Gửi để lập chỉ mục lại

Khi đã chỉnh sửa xong tệp robots.txt và xác nhận những thay đổi bằng công cụ kiểm tra, hãy sử dụng Google Search Console để yêu cầu lập chỉ mục lại cho các trang bị ảnh hưởng.

Các biện pháp tốt nhất để ngăn chặn lỗi 'Bị chặn bởi robots.txt' và quản lý các tệp robots.txt

Kiểm tra và giám sát thường xuyên

- Lên lịch kiểm tra thường xuyên : Thực hiện thói quen (hàng tháng hoặc hàng quý) để xem xét tệp robots.txt của bạn, đặc biệt là sau những bản cập nhật quan trọng cho trang web.

- Theo dõi Google Search Console : Sử dụng công cụ này để theo dõi cách tương tác với tệp robots.txt của bạn và kịp thời phát hiện với các lỗi thu thập dữ liệu hoặc cảnh báo.

Sử dụng các công cụ để quản lý hiệu quả

- Tận dụng các plugin và công cụ SEO : Sử dụng các công cụ SEO có thể giúp theo dõi và quản lý tệp robots.txt của bạn, cung cấp cảnh báo về các sự cố tiềm ẩn.

Làm rõ chỉ thị của bạn

- Sử dụng chỉ thị cụ thể : Đảm bảo chỉ thị ' Không cho phép ' trong tệp robots.txt của bạn là chính xác để tránh vô tình chặn nội dung quan trọng.

- Bình luận về các thay đổi : Bao gồm các bình luận (sử dụng #) trong tệp robots.txt của bạn để ghi lại mục đích của từng chỉ thị nhằm dễ hiểu và dễ quản lý nội dung tệp hơn sau này.

Học hỏi từ kinh nghiệm cá nhân và kinh nghiệm về ngành

- Tham khảo các nghiên cứu điển hình về SEO: Thường xuyên tham khảo các blog và nghiên cứu điển hình về SEO để biết thêm thông tin chi tiết về các cấu hình robots.txt không đúng phổ biến.

- Luôn cập nhật xu hướng SEO: Theo dõi thường xuyên các xu hướng và hướng dẫn SEO mới nhất để đảm bảo chiến lược của bạn phù hợp với những thay đổi của thuật toán công cụ tìm kiếm và các phương pháp đang được đánh giá cao.

Hãy nhớ rằng, việc duy trì một tệp robots.txt được tổ chức hợp lý và cấu hình chính xác là yếu tố cần thiết để các công cụ tìm kiếm có thể thu nhập dữ liệu và lập chỉ mục trang web của bạn một cách tối ưu

Làm chủ công cụ Google Search Console với Embarque

Hướng dẫn của chúng tôi cung cấp những phân tích chi tiết về cách khắc phục lỗi "Bị chặn bởi robots.txt" trong Google Search Console, một vấn đề phổ biến có thể cản trở hiệu suất SEO của trang web. Chúng tôi nhấn mạnh tầm quan trọng của việc hiểu rõ chức năng của tệp robots.txt, xác định và sửa các chỉ thị gây ra lỗi chặn, đồng thời đảm bảo các trang quan trọng không bị vô tình ngăn lập chỉ mục.

Đối với các chủ sở hữu website và chuyên gia SEO đang gặp khó khăn với vấn đề này, Embarque cung cấp các giải pháp chuyên biệt nhằm xử lý và khắc phục lỗi “Bị chặn bởi robots.txt”. Với trọng tâm là cải thiện khả năng truy cập của website đối với công cụ tìm kiếm, chuyên môn của chúng tôi trong tối ưu hóa SEO có thể đóng vai trò quan trọng trong việc cải thiện khả năng hiển thị và thứ hạng tìm kiếm của trang web bạn .

Để tìm hiểu cách Embarque có thể giúp bạn khắc phục tình trạng trang web 'Bị chặn bởi robots.txt' và nâng cao hiệu suất tìm kiếm trực tuyến, hãy truy cập trang web của chúng tôi hoặc liên hệ để được tư vấn giải pháp phù hợp riêng cho bạn.

Hãy để Embarque đồng hành cùng bạn trong việc tối ưu hóa tiềm năng SEO của trang web, đảm bảo rằng nội dung đầy giá trị của bạn được các công cụ tìm kiếm và đúng đối tượng khách hàng dễ dàng tiếp cận.

.svg)

.png)

%20(2).png)

%20(2).png)

%20(2).png)

.png)